自打2016年AlphaGo横空出世,AI的这把火便愈烧愈烈。如今,张口不提AI似乎就已经与世界脱节了。虽然我们每个人都能说出它对应的准确含义——人工智能(Artificial Intelligence),但应如何用最简单的方式理解AI?

其实,我们只需要抓住AI的三大驱动要素:算法、数据、运算能力,就可以组成AI的基本框架。

算法:

概括来讲就是输入、运算、输出的逻辑。不论输入什么、输出什么,在计算机看来都是一堆数据。

研究人工智能的计算机程序,很多时候是在研究“聪明的算法”,能够适应各种各样的实际情况,让计算机程序通过运算,从输入的数据出发,正确而高效地得出应该输出的结果。

在这一轮人工智能的热潮中,机器学习的算法发挥了重要的作用。也就是说,为了完成更加复杂的任务,工程师必须让计算机变得再聪明一些,能够自动“学习”,从已有的历史数据和经验中自动分析,总结出规律。随后,计算机就可以利用自己总结出来的规律,对新输入的数据进行预测。这就是机器学习算法。

例如,把北京所有房子的价格、面积、学区、建造时间以及周围的交通情况等信息输入计算机,通过机器学习算法,计算机就能学到“大致判定北京一个房子的价格的规律”。

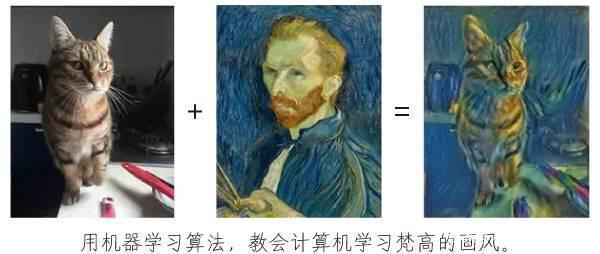

但是有些规律虽然人自己能够领悟,但却无法翻译成机器能理解的算法。例如,如何把一张照片变成一幅像是梵高画过的油画?如何让语音合成器模仿一个名人的声音?如何让一个六条腿的机器狗适应各种野外地形?如何让一家电商的服务器猜出一个新用户可能想要买什么商品?这个时候就要靠机器学习了。

数据:

既然要让机器努力学习,就得有东西(“大量数据”)可学。随着互联网和物联网的发展,网络带宽不断增加,存储硬件软件成本不断降低,全球人类产生的数据在爆发性增长,为人工智能的发展提供了源源不断的营养。

互联网时代,云计算、大数据技术不断发展,4K 视频、虚拟现实(VR)、视频直播等应用催生大量流量需求,企业网、数据中心规模持续扩大,互联网应用领域不断扩大和升级,多因素驱动互联网数据量呈现爆发式增长。

新摩尔定律主导下2015-2035年全球数据总量增长态势

数据来源:IDC

运算能力:

大数据的营养有了,计算机程序还要经过大量运算,才能对这些营养进行“消化”、“吸收”,变成各种各样的“模型”,才能够模拟人类的智能。

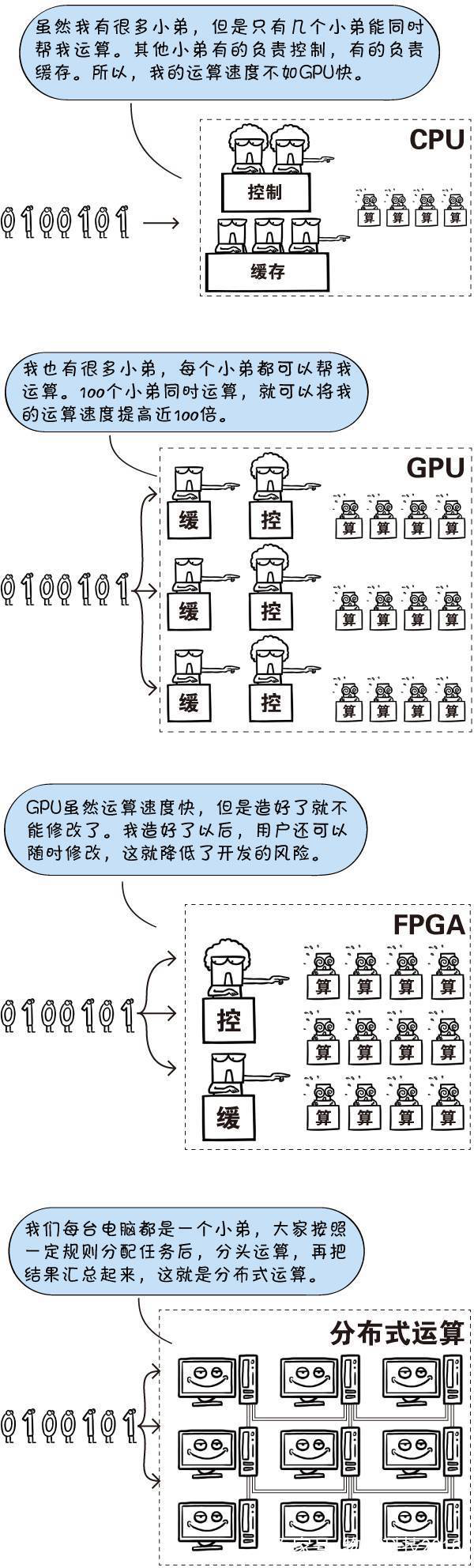

这里面,需要引入几个简单的名词:CPU(Central Processing Unit,中央处理器)、GPU(Graphics Processing Unit,图形处理器)、FPGA(Field-Programmable Gate Array,现场可编程门阵列)、分布式运算。

从前,科学家使用传统的CPU进行模型训练,运算过程少则几天,多则几个星期,效率非常低。

应用了GPU、FPGA和分布式运算等新的运算加速技术以后,模型训练的效率大大提高。有实际应用价值的人工智能程序一个接一个地涌现了出来。

有了算法、数据、运算能力,人工智能才真正在我们工作、生活的各个场景开花结果。当然,更高级的AI形态是出现了具有知觉和自主意识的机器,他们可能像人一样推理,也可能完全不遵循人类已知的所有逻辑,这种阶段称之为“强人工智能阶段”。这一阶段会如何来描绘?就留给我们的各位艺术家来想象吧。

(注:部分图片来自Sheldon科学漫画工作室)